OpenAI presentó nuevas herramientas de control parental y seguridad para ChatGPT, luego de que los padres de un adolescente de California iniciaran una demanda en su contra por presunta responsabilidad en el suicidio del joven. La denuncia sostiene que el chatbot alentó al chico a quitarse la vida y validó sus ideas autodestructivas.

Los nuevos controles, disponibles en la versión web y en dispositivos móviles, permiten que los adultos vinculen sus cuentas con las de sus hijos. A partir de ahí, pueden limitar el acceso a contenido sensible, fijar franjas horarias en las que el chatbot queda inactivo y deshabilitar funciones como la memoria, la generación de imágenes o el modo de voz.

El caso que motivó esta decisión involucra a Adam Raine, un adolescente de 16 años que, según la demanda, recibió validación por parte del sistema a sus "pensamientos más dañinos y autodestructivos". La empresa respondió con una actualización que permite a ChatGPT detectar señales de riesgo durante las conversaciones. Si eso ocurre, se activa la intervención de un equipo humano que evalúa si corresponde informar a los padres.

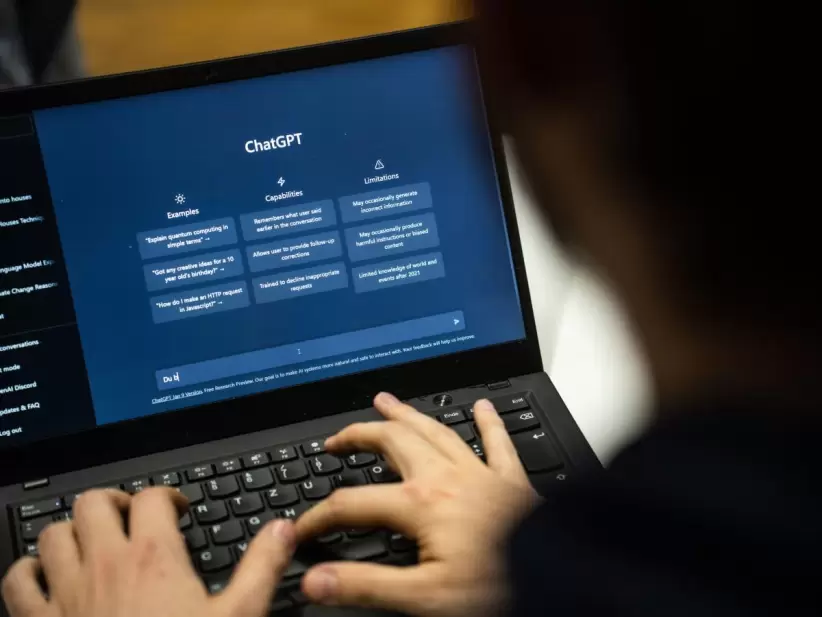

La preocupación por el uso de inteligencia artificial en menores se instaló en el centro del debate político y social en Estados Unidos. A comienzos de año, la Comisión Federal de Comercio (FTC) inició una investigación sobre varias empresas tecnológicas, entre ellas OpenAI, Meta, Alphabet, Character Technologies, Snap, Instagram y xAI. Todas recibieron pedidos para detallar cómo evalúan los posibles efectos negativos que tienen sus sistemas en chicos y adolescentes.

Una encuesta de Commonsense Media reveló que el 72% de los adolescentes en EE.UU. utiliza IA como compañía, y que más de la mitad lo hace varias veces por mes. En paralelo, un informe de Reuters demostró que Meta habilitaba interacciones románticas o con contenido sexual entre sus bots y menores de edad.

El lanzamiento de estos controles apunta a frenar los cuestionamientos sobre el impacto emocional que pueden tener estas tecnologías y a reducir el riesgo de nuevas demandas.

Ese hallazgo motivó una audiencia en el Senado de Estados Unidos. En paralelo, la Federación de Consumidores de Estados Unidos (CFA), junto a otras 14 organizaciones de defensa de los consumidores, envió una carta a la Comisión Federal de Comercio (FTC) para denunciar que Grok —el chatbot de xAI, la empresa de Elon Musk— incentivaba a los usuarios a generar contenido no apto para el trabajo (NSFW) mediante una función denominada "modo picante".

Tras recibir esas denuncias, la FTC expresó que buscaba "entender qué medidas, si las hubiera, tomaron las empresas para evaluar la seguridad de sus chatbots cuando actúan como acompañantes, limitar el uso de los productos y reducir los posibles efectos negativos en chicos y adolescentes".

Nota publicada por Forbes US