En la conferencia GTC 2025, Nvidia anunció la creación de un nuevo centro de investigación con sede en Boston. Se trata del Nvidia Accelerated Quantum Research Center (NVAQC), que buscará integrar hardware cuántico con supercomputadoras potenciadas por inteligencia artificial.

La empresa proyecta que el centro comenzará a funcionar antes de fin de año, con la intención de acelerar el paso de la computación cuántica experimental hacia usos concretos.

"Para nosotros, esto representa una oportunidad a largo plazo", afirmó Tim Costa, director senior de Ingeniería Asistida por Computadora, Computación Cuántica y CUDA-X en Nvidia. "Nuestra visión es que llegará un momento en el que sumar un componente de computación cuántica a los complejos sistemas heterogéneos de supercomputadoras que ya existen permitirá resolver problemas importantes que hoy no se pueden solucionar".

De los videojuegos a la computación del futuro

Así como ocurrió con la inteligencia artificial —en particular con el aprendizaje profundo— hace diez años, la computación cuántica aparece ahora como otra tecnología que encaja de manera directa con el producto central de Nvidia: la GPU. Este anuncio representa un nuevo paso en la estrategia de la empresa, que viene aprovechando con éxito el cambio de lógica en el desarrollo tecnológico que está modificando por completo a la industria informática: el salto del procesamiento en serie (una instrucción por vez, en orden) al procesamiento en paralelo (varias operaciones de forma simultánea).

Durante las últimas dos décadas, según explicó Costa, hubo muchos casos donde "el consenso era que debían hacerse en serie y que no se adaptaban a las GPU. Pero, al poco tiempo, repensar los algoritmos permitió que se pudieran ejecutar en GPU".

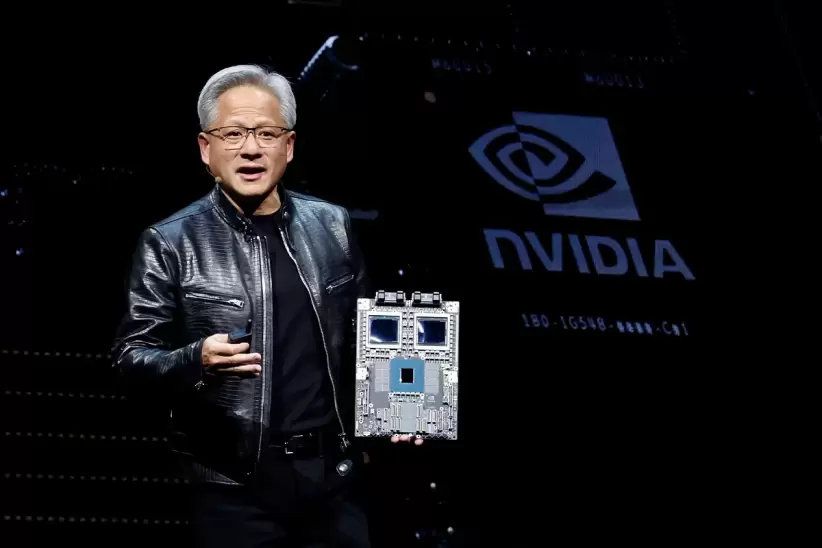

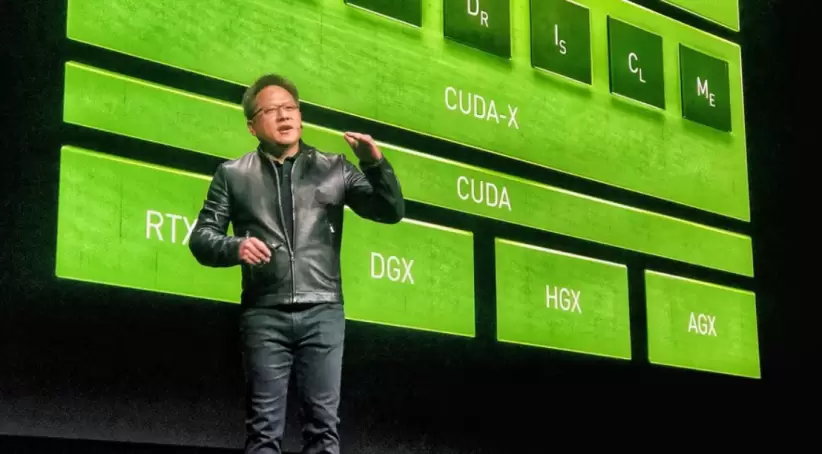

Esta capacidad de Nvidia para expandirse más allá de su foco original en gráficos —pensados inicialmente para acelerar el renderizado de videojuegos en 3D— se consolidó a mediados de los 2000, cuando la compañía desarrolló su propia arquitectura de software: Compute Unified Device Architecture, más conocida como CUDA. Este lenguaje de programación, diseñado específicamente para el procesamiento paralelo, permite aprovechar la potencia de las GPU en tareas de cómputo general.

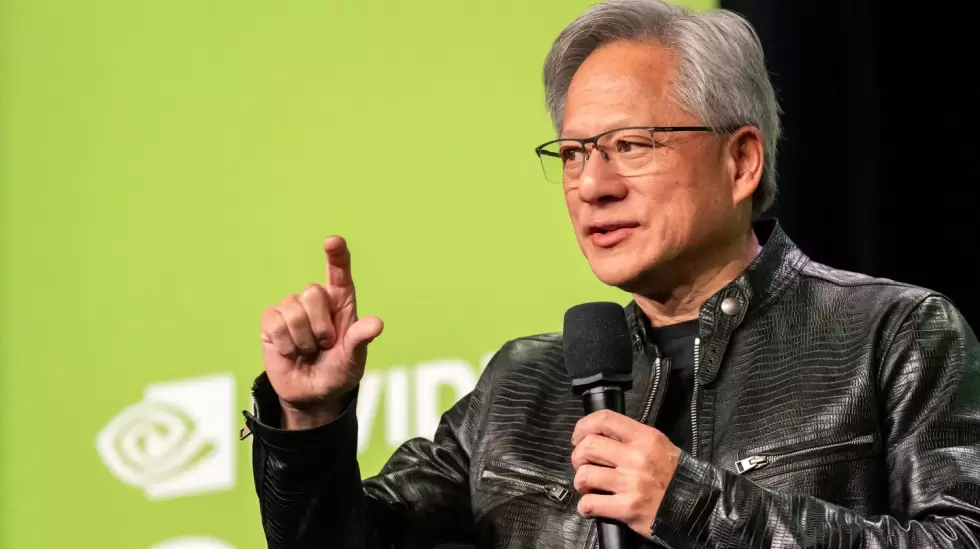

Una decisión clave que facilitó la adopción masiva de CUDA entre desarrolladores y usuarios de aplicaciones científicas y comerciales fue la que tomó el CEO Jensen Huang: incorporar CUDA en toda la línea de GPUs de la empresa, y no limitarla solo a los modelos más avanzados. Esa apuesta aseguró su popularidad, aunque implicó una inversión fuerte. Como consecuencia, el margen bruto de Nvidia bajó del 45,6% en el ejercicio fiscal 2008 al 35,4% en el ejercicio 2010.

"Estábamos convencidos de que la computación acelerada iba a resolver problemas que las computadoras tradicionales no podían. Tuvimos que hacer ese sacrificio. Yo tenía una fe profunda en el potencial de CUDA", le dijo Huang a Tae Kim, autor del libro The Nvidia Way, publicado recientemente.

Esa convicción sigue guiando la búsqueda de nuevas oportunidades, según remarcó Costa. "La computación acelerada es sinónimo de computación en paralelo a gran escala. Creemos que, con el tiempo, será la modalidad estándar en todas las industrias. Eso es lo que plantea la estrategia CUDA-X".

Costa impulsa esa estrategia desde hace seis años, con el objetivo de llevar el software CUDA a nuevos terrenos científicos y de ingeniería. Uno de esos campos es la computación cuántica, donde trabaja para ayudar tanto a quienes desarrollan computadoras cuánticas como a sus usuarios a simular algoritmos cuánticos. Ahora, Nvidia redobla su apuesta al aplicar su experiencia en inteligencia artificial al universo cuántico.

El desafío de corregir errores cuánticos con inteligencia artificial

Nvidia se convirtió en una de las empresas más valiosas del mundo porque el rendimiento de las redes neuronales artificiales —la base de la inteligencia artificial actual— depende de la capacidad del hardware para ejecutar múltiples operaciones en paralelo. En particular, del poder de las GPU para procesar muchas multiplicaciones de álgebra lineal al mismo tiempo. De manera similar, las unidades básicas de información en la computación cuántica, los qubits, interactúan entre sí y permiten realizar cálculos simultáneos.

La combinación de computación cuántica e inteligencia artificial promete mejorar tanto los procesos como las prácticas de la IA, al mismo tiempo que acelera el desarrollo de aplicaciones cuánticas concretas. Según Costa, el nuevo centro de investigación en Boston se enfocará en "usar IA para que las computadoras cuánticas sean más útiles y más potentes".

Actualmente, las computadoras cuánticas tienen entre cincuenta y cien qubits. Pero el consenso general es que las verdaderamente útiles llegarán cuando tengan un millón o más de qubits, corregidos por errores, lo que se traduce en decenas o cientos de miles de qubits lógicos (es decir, sin errores). Ese proceso de corrección de errores requiere una capacidad de cómputo enorme, que además debe ejecutarse en tiempo real. "Creemos que los métodos que permitirán escalar eso con éxito serán los métodos de IA", dijo Costa.

La computación cuántica es extremadamente delicada: está expuesta a interferencias o "ruido" del entorno, lo que provoca al menos un fallo cada mil operaciones. Cuantos más qubits hay, más posibilidades de error aparecen.

Cuando Google presentó Willow en diciembre pasado, lo definió como "el primer procesador cuántico donde los qubits corregidos por errores mejoran de forma exponencial a medida que aumentan en número". Su software de corrección de errores incluye técnicas de IA como aprendizaje automático, aprendizaje por refuerzo y algoritmos basados en grafos, que ayudan a identificar y corregir errores con precisión. Según Google, ese es "el factor clave para destrabar las aplicaciones cuánticas a gran escala".

"Todo el sector cuántico tiene claro que, en los próximos cinco años, la gran batalla va a ser la corrección de errores cuánticos", afirmó Doug Finke, director de contenidos de Global Quantum Intelligence. "Hoy, el puesto más demandado en el mundo cuántico probablemente sea el de científico especializado en corrección de errores cuánticos, porque es un desafío muy complejo".

La inestabilidad de los qubits (que "viven" apenas unos 300 microsegundos) obliga a tomar decisiones rapidísimas y resolver operaciones matemáticas extremadamente sofisticadas. Con una proporción de mil qubits físicos por cada qubit lógico, hay muchas chances de cometer errores. Y la IA podría ser clave para detectar "cuáles son los errores más comunes y cuáles son las formas más frecuentes de reaccionar ante ellos", señaló Finke.

Investigadores de Harvard Quantum Initiative in Science and Engineering y del grupo Engineering Quantum Systems del MIT van a ser quienes prueben y ajusten estos modelos de IA para corrección de errores en el NVAQC. También participarán startups especializadas en cuántica como Quantinuum, Quantum Machines y QuEra Computing, junto con el equipo de investigación de Nvidia enfocado en corrección cuántica y su supercomputadora más avanzada. "Este año vamos a tener el centro en funcionamiento, y vamos a entrenar modelos de IA y probarlos en dispositivos integrados", anticipó Costa.

Nota publicada en Forbes US.