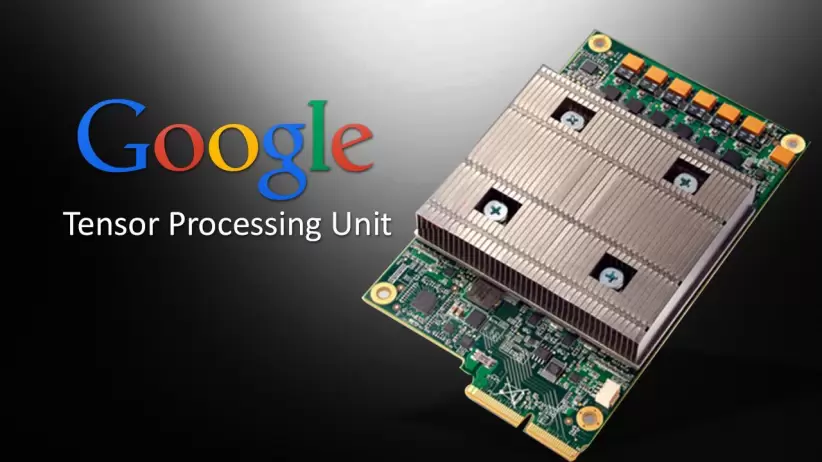

Google ha diseñado su propio chip personalizado llamado Tensor Processing Unit o TPU. Utiliza esos chips para más del 90% del trabajo de la compañía en entrenamiento de inteligencia artificial, el proceso de alimentar datos a través de modelos para que sean útiles en tareas como responder consultas con texto similar al humano o generar imágenes.

Google TPU está ahora en su cuarta generación. Google publicó un artículo científico que detalla cómo ha unido más de 4.000 chips en una supercomputadora utilizando sus propios interruptores ópticos desarrollados a medida para ayudar a conectar máquinas individuales.

Mejorar estas conexiones se ha convertido en un punto clave de competencia entre las empresas que construyen supercomputadoras de IA porque los llamados modelos de lenguaje grande que impulsan tecnologías como Bard de Google o ChatGPT de OpenAI se han disparado en tamaño, lo que significa que son demasiado grandes para almacenarlos en un solo chip.

En cambio, los modelos deben dividirse en miles de chips, que luego deben trabajar juntos durante semanas o más para entrenar el modelo. El modelo PaLM de Google, su modelo de lenguaje divulgado públicamente hasta la fecha, se entrenó dividiéndolo en dos de las supercomputadoras de 4000 chips durante 50 días.

Google dijo que sus supercomputadoras facilitan la reconfiguración de las conexiones entre chips sobre la marcha, lo que ayuda a evitar problemas y hacer ajustes para mejorar el rendimiento.

"La conmutación de circuitos facilita el enrutamiento de los componentes defectuosos", escribieron Google Fellow Norm Jouppi y el distinguido ingeniero de Google David Patterson en una publicación de blog sobre el sistema. "Esta flexibilidad incluso nos permite cambiar la topología de la interconexión de la supercomputadora para acelerar el rendimiento de un modelo de ML (aprendizaje automático)".

Si bien Google solo está publicando detalles sobre su supercomputadora, ha estado en línea dentro de la empresa desde 2020 en un centro de datos en el condado de Mayes, Oklahoma. Google dijo que la startup Midjourney usó el sistema para entrenar su modelo, que genera imágenes frescas después de recibir algunas palabras de texto.

En el documento, Google dijo que, para sistemas de tamaño similar, sus chips son hasta 1,7 veces más rápidos y 1,9 veces más eficientes energéticamente que un sistema basado en el chip A100 de Nvidia que estaba en el mercado al mismo tiempo que el TPU de cuarta generación. .

Un portavoz de Nvidia se negó a comentar. Google dijo que no comparó su cuarta generación con el actual chip insignia H100 de Nvidia porque el H100 llegó al mercado después del chip de Google y está hecho con tecnología más nueva.

Google insinuó que podría estar trabajando en un nuevo TPU que competiría con la Nvidia H100, pero no proporcionó detalles. Jouppi dijo a Reuters que Google tiene "una fuente saludable de futuros chips".